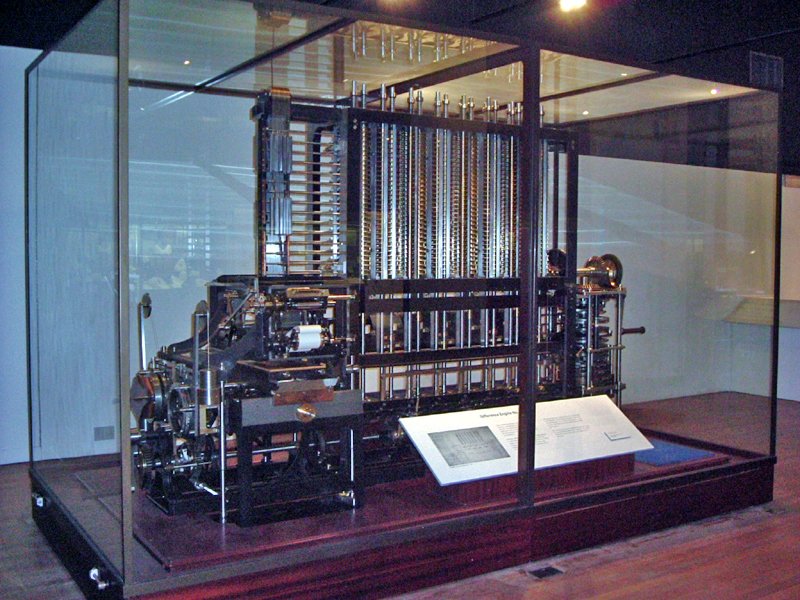

O grande pioneiro da história dos computadores foi Charles Babbage, um brilhante matemático, filósofo e engenheiro britânico do século XIX. Fascinado pela ideia de automatizar cálculos matemáticos, Babbage observou as falhas humanas nas tabelas matemáticas manuais e idealizou uma máquina que pudesse executar esses cálculos de forma precisa e automática. Em 1822, ele concebeu a Máquina Diferencial, um dispositivo mecânico projetado para calcular e imprimir tabelas matemáticas sem erros.

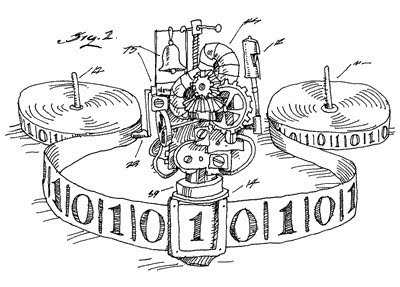

No entanto, sua invenção mais ambiciosa veio anos depois: a Máquina Analítica, concebida na década de 1830. Diferente de qualquer outra invenção da época, essa máquina revolucionária possuía os princípios básicos dos computadores modernos, como uma unidade de processamento, memória e até a capacidade de receber instruções por meio de cartões perfurados, um conceito inspirado nos teares automatizados de Joseph Jacquard.

Embora a Máquina Analítica nunca tenha sido completamente construída devido a limitações tecnológicas e financeiras, suas ideias influenciaram gerações futuras. A matemática Ada Lovelace, colaboradora de Babbage, reconheceu o potencial dessa máquina além dos simples cálculos numéricos e escreveu o primeiro algoritmo da história, tornando-se a primeira programadora do mundo.

As contribuições de Babbage foram visionárias e, mesmo que sua máquina nunca tenha se tornado funcional em sua época, suas ideias pavimentaram o caminho para o desenvolvimento dos computadores modernos, consolidando-o como o verdadeiro "pai da computação".

Embora Charles Babbage tenha sido o arquétipo do inventor visionário, a contribuição de Ada Lovelace foi igualmente fundamental para a história da computação. Augusta Ada King, Condessa de Lovelace, filha do famoso poeta Lord Byron, cresceu em um ambiente que mesclava ciência e arte, sob a rígida orientação de sua mãe, Anne Isabella Byron, que a incentivou a estudar matemática e lógica desde cedo. Esse conhecimento raro para uma mulher da época a levou a um encontro decisivo com Charles Babbage em 1833, dando início a uma colaboração que mudaria a história da computação.

Diferente de Babbage, que via sua Máquina Analítica apenas como uma ferramenta para automatizar cálculos matemáticos complexos, Ada Lovelace percebeu algo extraordinário: a máquina poderia ser programada para manipular não apenas números, mas qualquer tipo de símbolo ou informação, tornando-se um dispositivo capaz de executar diferentes tarefas com base em comandos pré-definidos. Essa visão inovadora antecipou em mais de um século os conceitos fundamentais da computação moderna.

Em 1843, Lovelace traduziu um artigo do matemático italiano Luigi Federico Menabrea sobre a Máquina Analítica e, além da tradução, acrescentou um conjunto extenso de notas explicativas, que acabaram sendo mais longas e mais relevantes do que o próprio artigo original. Nessas notas, ela detalhou como a máquina poderia ser programada, descrevendo um algoritmo para calcular os números de Bernoulli — considerado o primeiro programa de computador da história. Seu entendimento de que as máquinas poderiam ser usadas para processar qualquer tipo de dado estruturado, e não apenas números, antecipou a ideia de computadores de propósito geral, como os que conhecemos hoje.

Apesar de seu trabalho inovador, suas ideias não foram compreendidas em sua época, e seu impacto só foi plenamente reconhecido no século XX, quando a computação moderna começou a tomar forma. Ada Lovelace faleceu prematuramente aos 36 anos, mas seu legado perdura como um dos pilares da ciência da computação. Hoje, ela é celebrada como a primeira programadora da história, e sua visão profética ajudou a definir o que conhecemos como programação de computadores. Seu nome inspira inovações tecnológicas e é lembrado anualmente no Ada Lovelace Day, uma data dedicada a mulheres na ciência, tecnologia, engenharia e matemática (STEM).

A Máquina de Turing era uma concepção abstrata, composta por uma fita infinita e uma cabeça de leitura/escrita que se movia sequencialmente, interpretando símbolos e alterando estados de acordo com um conjunto predefinido de regras. Esse modelo não apenas ajudou a definir os fundamentos da computação, mas também provou que qualquer problema matemático que pudesse ser resolvido por um algoritmo poderia ser processado por essa máquina teórica — um princípio que ainda sustenta os computadores modernos.

Além de formalizar a ideia de computação, Turing abordou uma das questões mais importantes da lógica matemática: a decidibilidade, isto é, a capacidade de determinar se um problema pode ser resolvido de maneira algorítmica. Seu trabalho ajudou a responder ao Entscheidungsproblem, proposto por David Hilbert, provando que não existe um algoritmo universal capaz de determinar a verdade ou falsidade de todas as proposições matemáticas, estabelecendo assim os limites fundamentais da computação.

A genialidade de Turing, no entanto, não se limitou ao campo teórico. Durante a Segunda Guerra Mundial, ele desempenhou um papel crucial na quebra do código Enigma, utilizado pela Alemanha Nazista para criptografar mensagens militares. Trabalhando no centro de inteligência de Bletchley Park, Turing projetou a Bombe, uma máquina eletromecânica que ajudou a decifrar mensagens criptografadas e foi essencial para antecipar estratégias do Eixo, reduzindo significativamente a duração da guerra e salvando milhares de vidas.

Após a guerra, Turing continuou suas pesquisas no desenvolvimento dos primeiros computadores digitais programáveis e contribuiu para a inteligência artificial, introduzindo o conceito do Teste de Turing, um experimento que avalia a capacidade de uma máquina em demonstrar comportamento inteligente semelhante ao humano.

Infelizmente, apesar de sua imensa contribuição para a ciência e para a vitória aliada, Turing sofreu perseguição pelo governo britânico devido à sua homossexualidade, considerada crime na época. Foi condenado em 1952 a um tratamento de castração química, o que o levou ao isolamento e, posteriormente, à sua trágica morte em 1954, aos 41 anos. Somente décadas depois, o governo britânico reconheceu seu erro, concedendo a Turing um perdão póstumo em 2013, e hoje ele é celebrado como um dos maiores pioneiros da computação.

O impacto de Alan Turing na ciência da computação é imensurável. Sua visão teórica estabeleceu os alicerces dos computadores modernos, e sua coragem intelectual redefiniu os limites da lógica matemática, criptografia e inteligência artificial. Seu legado vive nos dispositivos que usamos diariamente e na maneira como entendemos a computação.